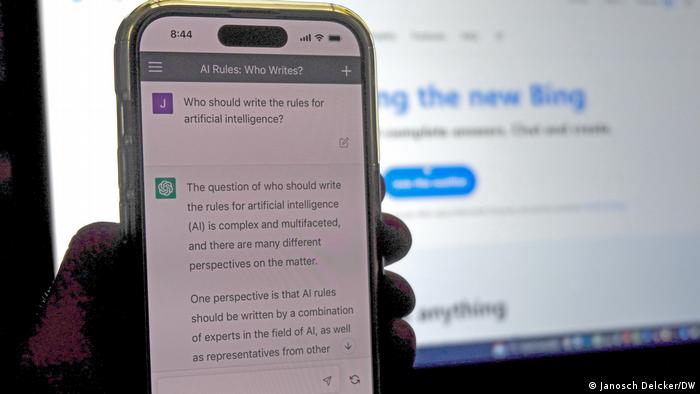

Wer soll die Regeln schreiben für das Zeitalter der Künstlichen Intelligenz (KI)? Fragt man ChatGPT, das wohl bekannteste KI-System unserer Tage, sagt es, eine Antwort sei – nun ja – komplex: “Es gibt viele verschiedene Sichtweisen auf dieses Thema”, so der Chatbot der Technologiefirma OpenAI.

Aber, so die Software weiter, es bestünde Konsens darüber, dass Regeln “von einer Vielzahl von Interessengruppen und Experten gemeinsam entwickelt werden” sollten. Das schließe Regulierungsbehörden, Technologieunternehmen, Forschende sowie Nichtregierungsorganisationen und Interessengruppen ein.

Lilian Edwards, Professorin für Recht, Innovation und Gesellschaft an der Newcastle University, sagt, sie würde der Einschätzung des Chatbots “nicht widersprechen.” Aber, so fügt sie gegenüber der DW hinzu, “diese Regeln müssen auch bindend sein.”

Innerhalb weniger Monate ist ChatGPT zum prominentesten Vertreter einer neuen Generation sogenannter “generativer KI”-Systeme aufgestiegen; andere Programme heißen LaMDA, DALL-E oder Stable Diffusion. Sie erschaffen Text, Computercode, Bilder oder sogar Videomaterial scheinbar aus dem Nichts – mit Ergebnissen, die so überzeugend sind, dass es oft unmöglich ist zu erkennen, dass sie nicht aus Menschenhand stammen.

Die Technologie, da sind sich Fachleute einig, wird die Art und Weise revolutionieren, wie Menschen arbeiten oder online Informationen finden. Gleichzeit warnen sie, dass sie Millionen von Menschen den Job kosten oder für Desinformation missbraucht werden könnte. Das hat eine Debatte befeuert, welche Regeln nötig sind für KI.

“Wir brauchen Regulierung”, so Rechtsprofessorin Lilian Edwards – sowohl, indem bestehende Gesetze angewandt als auch neue geschaffen werden. Gleichzeitig, so fügt sie hinzu, beherrschen Programme wie ChatGPT zwar die Schlagzeilen, seien aber “bei weitem nicht die einzige Entwicklung in der KI.” Und sie warnt: “Die Gefahr ist real, dass sie den Blick auf das Wesentliche verstellen.”

Hochkomplexe KI, für alle zugänglich

Forschung an künstlicher Intelligenz reicht zurück bis in die 1950er Jahre. Aber erst seit den frühen 2010er Jahren verbauen Firmen KI zunehmend auch in Alltagstechnologie. Und erst in den letzten Jahren wurden die Programme rapide immer besser darin, selbst komplett neue Inhalte zu erstellen

Aber obwohl diese Durchbrüche in der Fachwelt Wellen schlugen, nahm die breite Öffentlichkeit davon wenig Notiz – bis OpenAI Ende November 2022 seinen ChatGPT-Prototyp ins Netz stellte. Das Programm ist denkbar einfach zu bedienen: Auf einer Webseite kann man ihm über eine Textleiste Aufgaben stellen. Fragt man nach einer Zusammenfassung von Goethes Faust im Stil eines 14-Jährigen, spuckt der Chatbot einen Text aus, der sich liest, als käme er aus der Feder eines Teenagers. Bittet man das System um denselben Text im Stil Thomas Manns, bekommt man ihn in spätrealistischer Prosa.

Über eine Webseite kann jeder online auf ChatGPT zugreifen

Zum ersten Mal wurde mit ChatGPT solch ein hochentwickeltes KI-Tool kostenlos online zur Verfügung gestellt – und es löste eine Debatte darüber aus, was der Aufstieg generativer KI für menschliche Kreativität bedeutet. Lehrende an Universitäten riefen “den Tod der Hausarbeit” aus. Zeitungen kündigten an, die Software ihren Reportern künftig beim Schreiben von Nachrichten an die Seite zu stellen.

Wichtig sei nun, ein Bewusstsein für die Funktionsweise von KI-Systemen zu stärken, indem man sie beispielsweise in Schullehrpläne aufnimmt, so Joanna Bryson, Professorin für Ethik und Technologie an der Berliner Hertie School. “Kinder sollten das in der Schule lernen und dann nach Hause gehen und ihren Eltern davon erzählen”, sagt sie der DW.

In Nordrhein-Westfalen kündigte Landesbildungsministerin Dorothee Feller schon konkrete Schritte in diese Richtung an. Anstatt KI aus Schulen zu verbannen, arbeitet ihre Behörde nun an einem Handlungsleitfaden für einen “sicheren Umgang mit KI-Anwendungen” im Unterricht, so sagte die Politikerin Ende Februar.

Wie aus einem Science-Fiction-Film?

Gleichzeit wurde die anfängliche Euphorie getrübt, als US-Technologieriese Microsoft diesen Monat bekannt gab, seine Suchmaschine Bing mit einer noch leistungsfähigeren Version von ChatGPT ausgestattet zu haben und einer kleiner Gruppe Ausgewählter erlaubte, damit herumzuspielen. Kurz darauf begannen die Tester, Screenshots von unheimlichen Gesprächen mit der Software zu veröffentlichen: Mal wurde der Chatbot schroff und konfrontativ; dann begann er, sich selbst als “Sydney” zu bezeichnen; vereinzelt äußerte er sogar den Wunsch, ein Mensch zu sein.

Schnell beteuerten Fachleute, dass das Programm keine Persönlichkeit habe oder Emotionen empfinden könne. Seine menschenähnlichen Äußerungen ließen sich durch die Technologie erklären, die ihm zugrunde liegt: Das System analysiert riesige Textmengen aus dem Internet. Das macht es unglaublich gut darin, vorauszusagen, welches Wort einem vorherigen folgen sollte – so gut, dass sich der Chatbot wie ein Mensch mit Emotionen anhört.

Wissenschaftlerin Bryson forscht seit den 1990er Jahren zu ethischen Fragen rund um KI

Nichtsdestotrotz sorgten die Vorfälle für Aufruhr in den sozialen Medien. Sie markierten einen Wendepunkt, so Ethikprofessorin Joanna Bryson: Menschen hätten erkannt, dass es immer schwieriger würde, menschliche Schöpfungen von denen von KI-Systemen zu unterscheiden. Diese Erfahrung sei “etwas völlig Neues”. Dennoch ist Bryson der Meinung, dass “die Regeln, die wir seit etwa einem Jahrzehnt empfehlen, immer noch ausreichend sind”.

Zeit für Gesetze

Seit Mitte der 2010er Jahre haben Hunderte von Institutionen – von Technologie-Konzernen bis hin zur katholischen Kirche oder internationalen Organisationen wie der UN – unverbindliche Richtlinien für eine verantwortungsvolle Entwicklung und Nutzung von KI veröffentlicht. Diese Texte waren höchstwahrscheinlich die Quellen, aus denen ChatGPT seine eingangs zitierte Schlussfolgerung gezogen hat.

Inzwischen bestünde jedoch Einigkeit darüber, dass freiwillige Leitlinien allein nicht ausreichten, so Rechtswissenschaftlerin Lilian Edwards.

Seit Jahren arbeiten Regierungen rund um die Welt deshalb auch an neuer Gesetzgebung. Ein Überblick der Organisation für wirtschaftliche Zusammenarbeit und Entwicklung (OECD) listet politische Initiativen in über 65 Ländern, von Argentinien bis Usbekistan. Doch nur vereinzelt sind daraus bisher harte Gesetze hervorgegangen. Die Ausnahme ist China, das letztes Jahr weitreichende KI-Gesetze verabschiedet hat.

Im Westen richten sich alle Augen auf die Europäische Union. Bereits 2018 begann die EU – die weltweit als Vorreiter bei der Regulierung von neuer Technologie gilt – mit der Arbeit an einem Gesetzespaket, das mittlerweile als “KI-Akt” bezeichnet wird. Fünf Jahre später werden EU-Institutionen dieses Jahr mit ihren abschließenden Diskussionen beginnen. Einmal verabschiedet, könnten die Regeln Unternehmen dazu zwingen, gegenüber Kunden offenzulegen, wann immer sie mit Chatbots kommunizieren.

Nur die Spitze des Eisbergs

Fachleute wie Edwards warnen jedoch, dass generative KI wie ChatGPT nur die Spitze des Eisbergs ist. Längst haben sowohl Firmen als auch öffentliche Einrichtungen damit begonnen, ähnliche KI-Techniken einzusetzen, um Entscheidungen in Feldern von der Strafjustiz bis hin zu innerer Sicherheit zu automatisieren – Bereiche, bei denen das Risiko, dass KI-Systeme dauerhaften Schaden anrichten können, noch größer ist.

Bezeichnenderweise hat auch der CEO des Unternehmens hinter ChatGPT eine ähnliche Warnung ausgesprochen. Sam Altman von OpenAI schrieb Mitte Februar auf Twitter,: “Obwohl die KI-Tools der aktuellen Generation uns keine große Angst machen sollten, sind wir aus meiner Sicht nicht weit entfernt von Anwendungen, die potentiell gefährlich sind.”

Das kommende KI-Regelwerk der EU sieht deshalb besonders strenge Regeln für sogenannte “Hochrisiko-Anwendungen” vor. So will der Staatenverbund unter anderem sicherstellen, dass KI-Systeme nicht gegen Minderheiten diskriminieren. Und die Hoffnung in Brüssel ist, dass diese Gesetze zum “Goldstandard” für KI-Regulierung werden, der Regierungen weltweit zu ähnlichen Regeln inspiriert.